Webサービスやクラウドアプリケーションにおいて、アクセスの急増や一部サーバの障害は避けられない課題です。

ユーザー数が増えれば増えるほど、処理が追いつかなくなったり、トラフィックの偏りが原因でサービスが不安定になることも珍しくありません。

そんな中、こうした問題を裏側で解決し、サービスの安定稼働を支える縁の下の力持ちが「ロードバランサー」です。

ロードバランサーは、アクセスを効率的に振り分けることで、個々のサーバの負荷を最適化し、サービス全体の応答速度や信頼性を向上させます。

石田先生

石田先生ユーザーにとっては意識されることの少ない存在ですが、私たちが普段スムーズにWebサービスを利用できているのは、この仕組みのおかげだと言えるでしょう。

ロードバランサーとは

ロードバランサーは、複数のサーバやネットワーク機器に対して、処理の負荷を分散させる装置や仕組みのことを指し、“負荷分散装置”とも呼ばれます。

これは、アクセスが特定のサーバに集中することを避け、全体のリソースを有効に活用するための中核的な存在です。

アクセスの集中を避けることで、システムの可用性や処理性能を高め、全体の安定稼働を実現します。

たとえば、あるリクエストはサーバAに、別のリクエストはサーバBにといった具合に、効率よく振り分けが行われます。

このように、個々のリクエストを適切なサーバへ分散させることによって、応答時間の均一化やユーザー体験の向上が期待できます。

アクセスの集中によって通信が遅くなることを防げるのは便利ですね!

また、ロードバランサーは単なる振り分け役にとどまらず、障害発生時の対応にも優れています。

各サーバの死活確認を行う「ヘルスチェック」により、定期的に各サーバの応答状況を監視し、異常を検知した場合にはそのサーバを振り分け対象から除外します。

障害が起こった時にも便利なんですね。

これにより、ユーザーが障害に気づくことなくサービスを利用し続けることができ、システム全体の信頼性を大きく向上させます。

ヘルスチェックは、HTTPリクエストやTCP接続の成功・失敗といった複数の方法で行われ、検知精度を高める工夫もなされています。

さらに、ロードバランサーはスケーラビリティ(拡張性)にも優れており、サーバを増減させながら柔軟に運用できるという利点があります。

新しいサーバを追加しても、ロードバランサー側で適切に振り分けが行われるため、システム全体の構成を変えることなく処理能力を強化できます。

これにより、繁忙期やキャンペーン時など急激なアクセス増にも対応可能となり、サービス品質を維持しやすくなります。

Webサービスやクラウド環境など、負荷が変動しやすい現代のシステムにおいては、こうした信頼性・柔軟性・拡張性を兼ね備えたロードバランサーは、もはや欠かせないインフラ要素と言えるでしょう。

ロードバランサーの基本的な役割

ロードバランサーの主な役割は、クライアントからのリクエストを複数のバックエンドサーバに均等に振り分けることです。

これにより、特定のサーバだけに負荷が集中することを防ぎ、全体のパフォーマンスを維持することが可能になります。

負荷分散がロードバランサーのメインの役割なんですね。

また、処理能力を分散することで、ボトルネックの発生を抑え、システム全体の安定稼働を確保するという点でも重要な役割を果たしています。

ロードバランサーは単にリクエストを順番に振り分けるだけでなく、各サーバの現在の状態や接続数、応答速度などを総合的に判断して最適なサーバを選定します。

このため、動的な負荷変動にも柔軟に対応できるのが特徴です。

さらに、アクセスが急増した際には、一時的に新たなサーバを追加することで、サービスの品質を維持することも可能です。

具体的には以下のような動作を行います。

- サーバの応答時間を監視し、最適なサーバへ振り分ける(リアルタイムで性能を評価)

- サーバの障害を検知して、正常なサーバへトラフィックを誘導する(サービスの高可用性を確保)

- セッションの一貫性を確保する(スティッキーセッション)

- サーバのリソース使用率などを考慮して、過負荷を回避する(リソースの最適配分)

ロードバランサーの通信の流れ

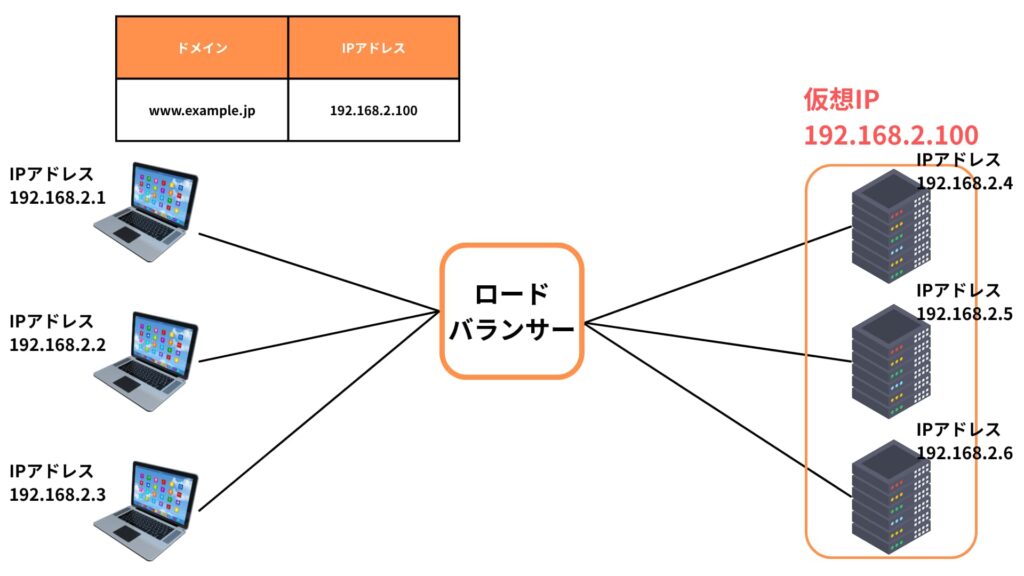

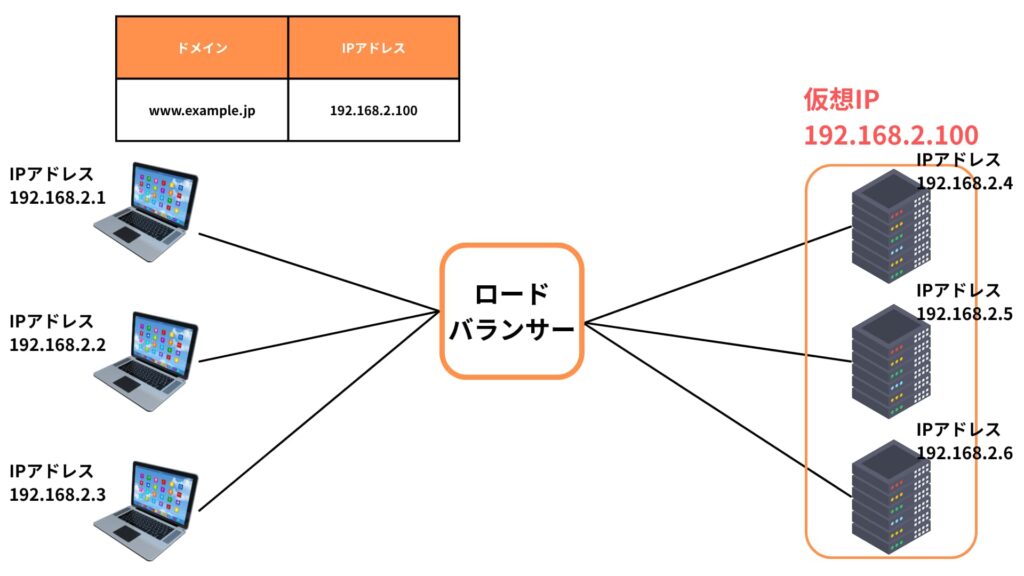

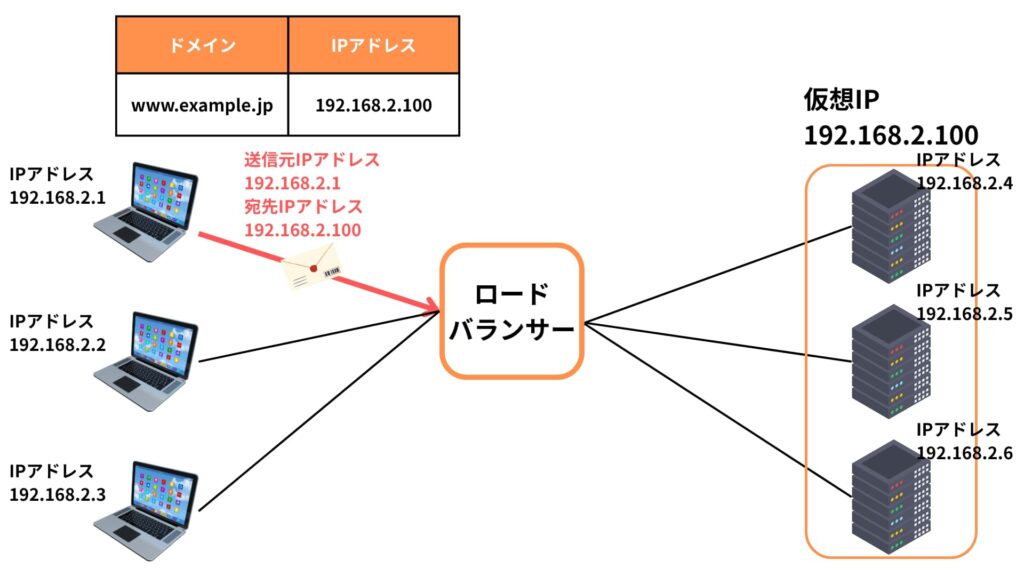

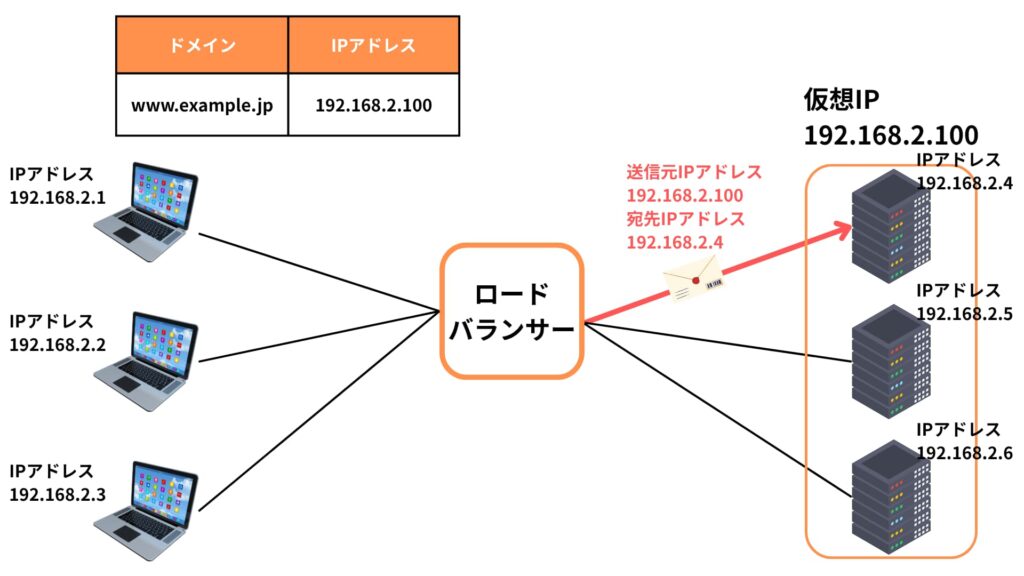

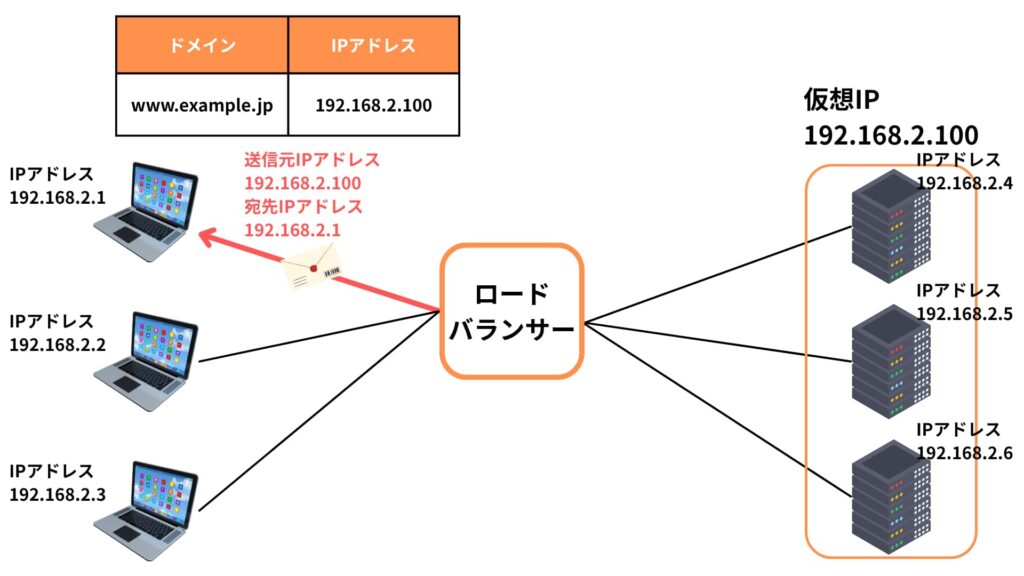

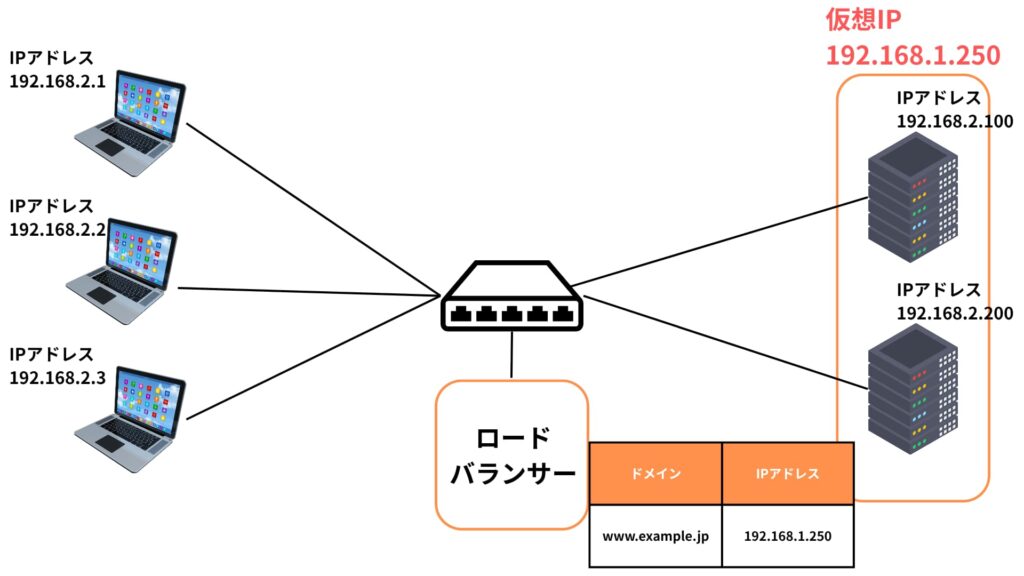

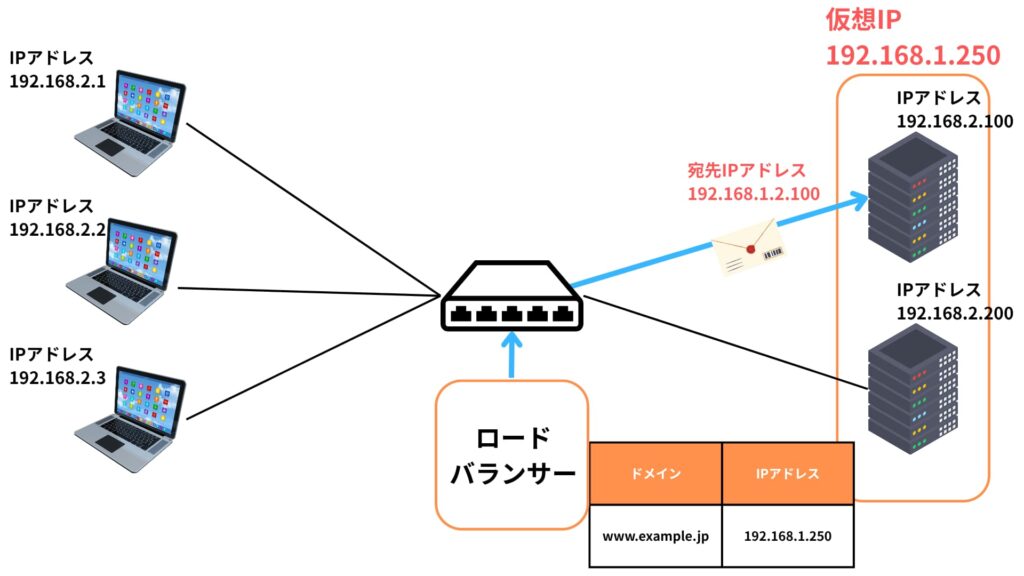

ロードバランサーは、クライアントからのリクエストを複数のサーバに振り分けるだけでなく、「仮想IPアドレス(VIP)」という仕組みを用いて通信の中継を行います。

この仮想IPアドレスは、クライアントにとってはひとつの宛先に見えるため、システム構成の複雑さを隠蔽しつつ柔軟な負荷分散を実現します。

ロードバランサーが仲介することで、クライアントと実サーバ間の直接的な接続を避け、安全性と柔軟性を両立できます。

具体的な流れを見てみましょう。

- ロードバランサーは、対象となる複数のサーバをひとつに束ねた「仮想IPアドレス(VIP)」を生成します。このVIPは、DNSで解決されるIPアドレスとして使われ、クライアントに公開される表向きのアドレスです。実際にはどのバックエンドサーバにも属さず、ロードバランサー自身のアドレスとなります。

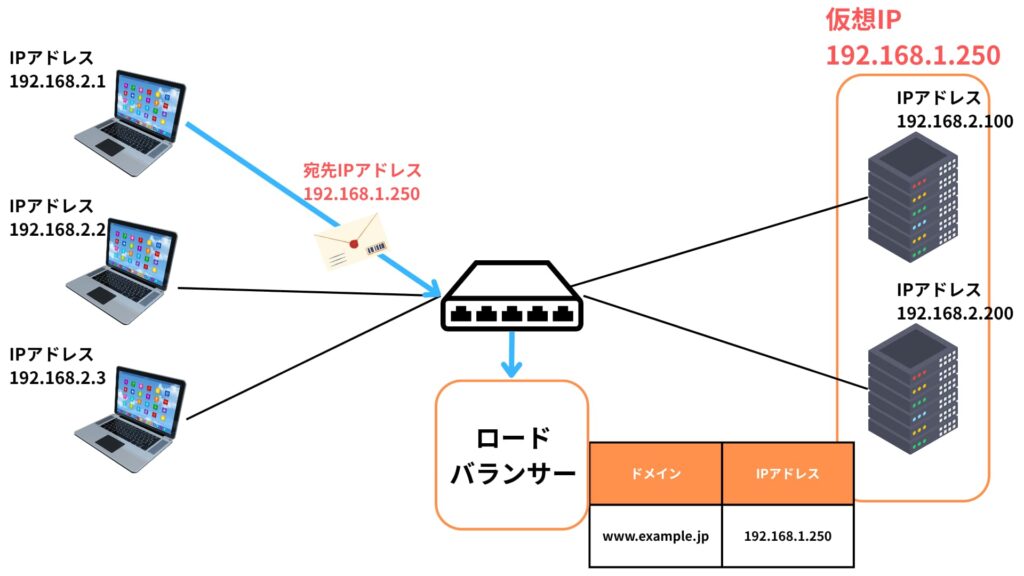

- クライアントは、Webブラウザやアプリを通じて目的のサービスへアクセスしようとすると、この仮想IPアドレスをあて先としたパケットを送信します。クライアントは背後のサーバ構成や負荷分散の仕組みを意識することなく、単一のサーバに接続しているように見えます。

- このパケットは、インターネットやイントラネット経由でロードバランサーに到達します。ロードバランサーはあたかもリクエストの最終到達点のように振る舞い、パケットをいったん受け取ります。

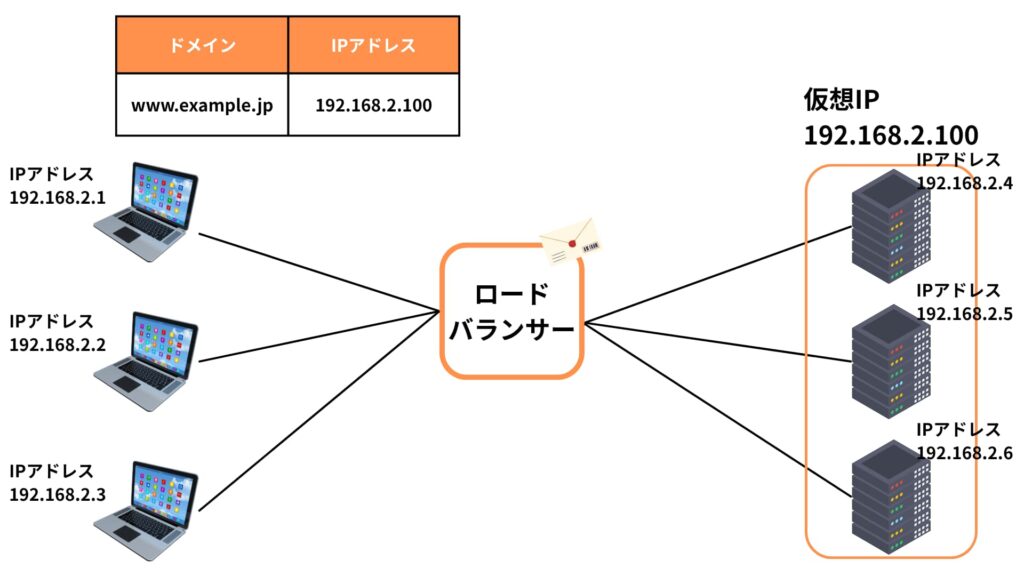

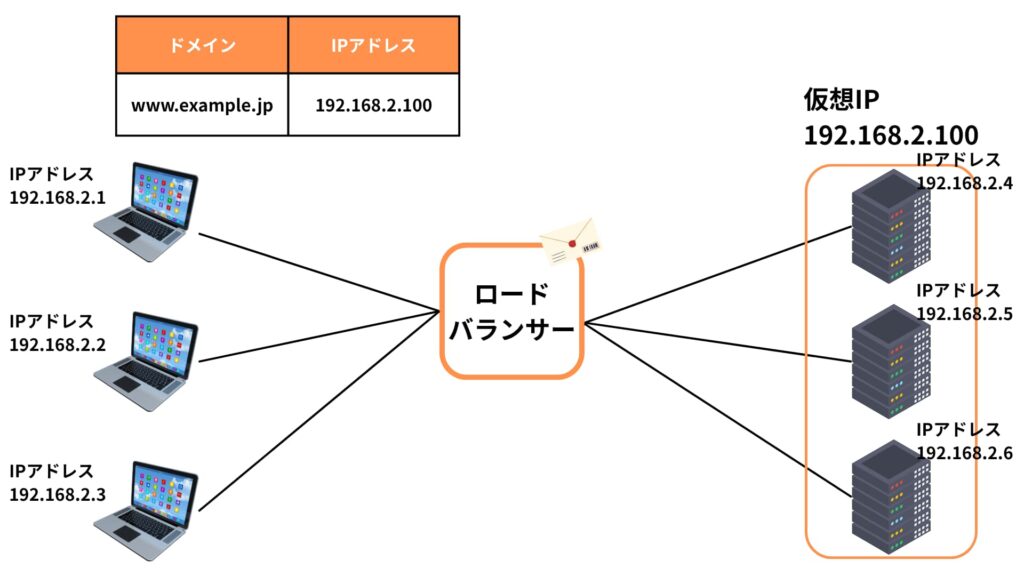

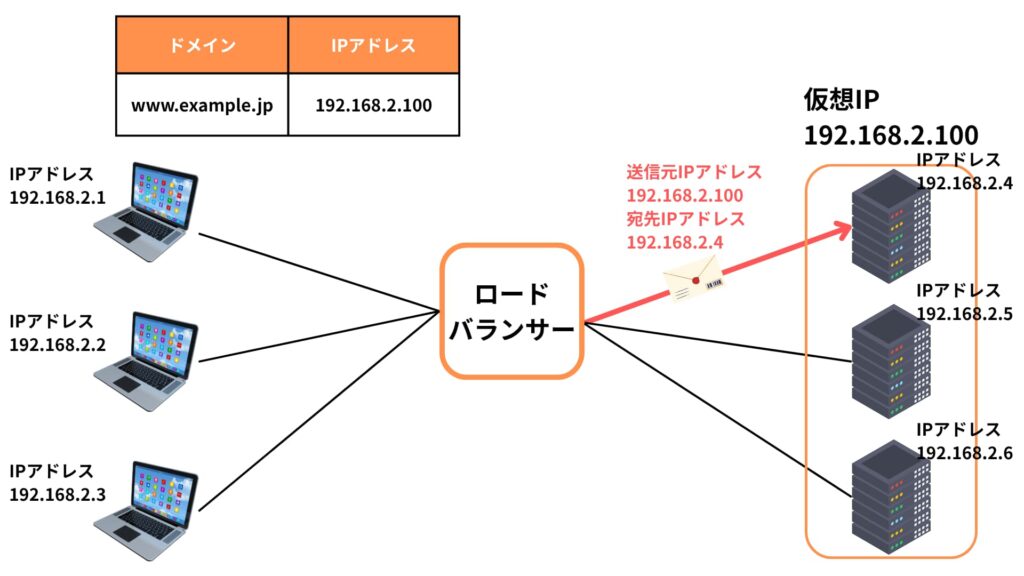

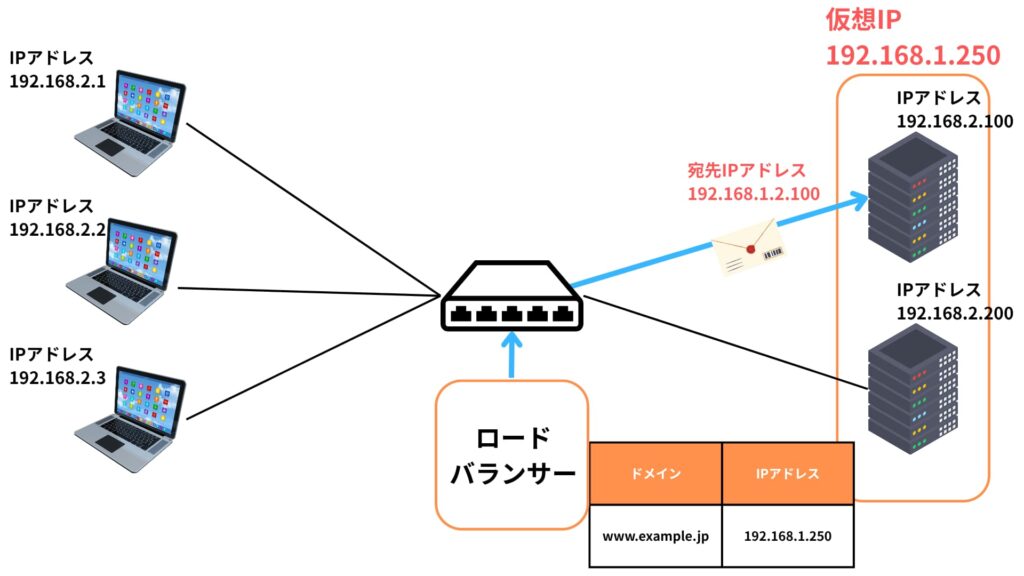

- ロードバランサーは、パケットを解析し、送信元やセッション情報、負荷状況などに応じて最適なバックエンドサーバを選定します。その後、宛先IPアドレスを書き換えて、選ばれた実サーバへパケットを転送します。この処理はNAT(ネットワークアドレス変換)により実現され、セッションの整合性を保ったまま行われます。

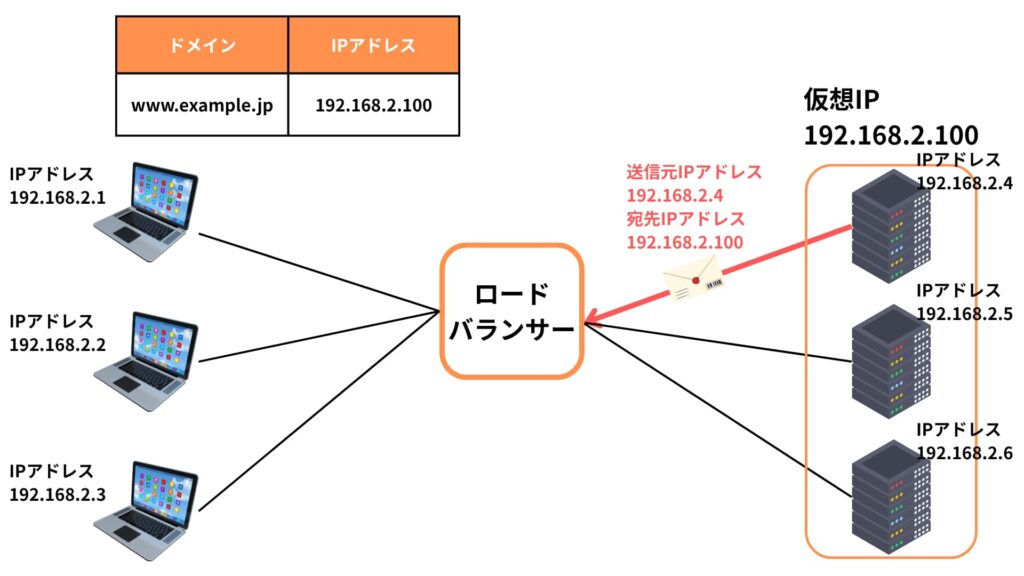

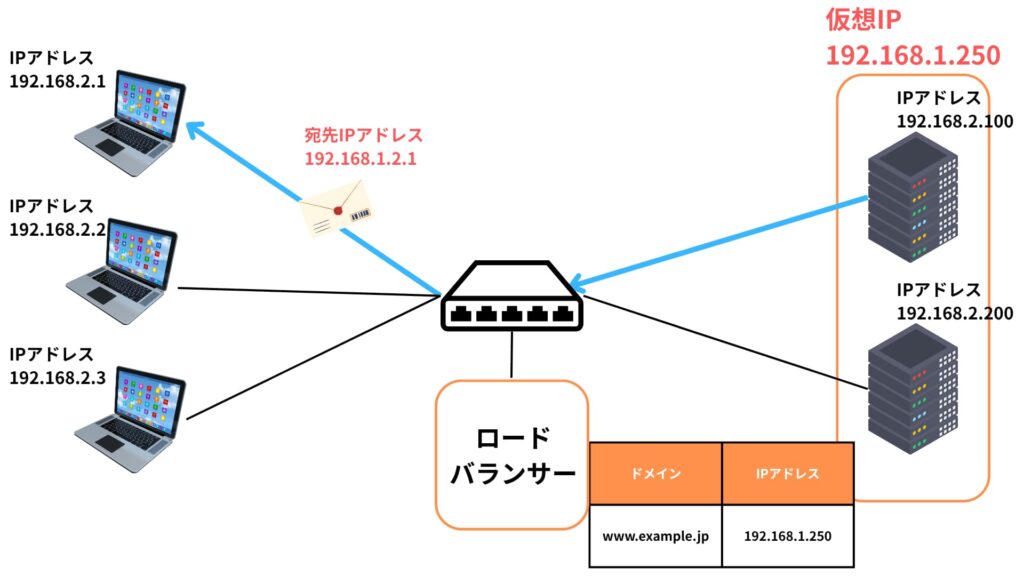

- 実サーバは、そのパケットをクライアントからの正規のリクエストとして受け取り、アプリケーション処理やデータベース照会などの処理を行います。処理が完了すると、レスポンスが生成され、ロードバランサーへ返されます。

- ロードバランサーは、受け取ったレスポンスの送信元アドレスを再び仮想IPに書き戻し、クライアントへ返送します。クライアント側からは、最初から最後まで仮想IPを通じてやり取りしているように見えるため、裏側でどのサーバが処理したかは完全に透過的です。

このようにロードバランサーは、仮想IPアドレスという統一された窓口を通じて、複数の実サーバへのトラフィック分散と中継を実現しています。

これにより、サービスのスケーラビリティ(拡張性)や可用性(信頼性)が大きく向上し、障害時にも柔軟な対応が可能になります。

また、通信の中継ポイントとして、アクセス制御やSSL終端、ログ収集といったセキュリティ・運用上の高度な制御を行えるのも大きなメリットです。

結果として、全体のシステム運用を効率化しつつ、高品質なサービス提供を支える重要な仕組みとなっています。

主な負荷分散アルゴリズム

ロードバランサーには、トラフィックを振り分ける際のアルゴリズムがいくつかあります。

ここからは、特に重要な6つのアルゴリズムを解説します。それぞれの特徴や使いどころを理解することで、最適な負荷分散設計が可能になるでしょう。

ラウンドロビン(Round Robin)

ラウンドロビンは、リクエストを順番に各サーバへ均等に割り振る最もシンプルな方式です。

すべてのサーバがほぼ同じ性能で構成されている場合に効果を発揮しやすく、実装も簡単です。

ただし、サーバのスペックや負荷に差がある環境では、結果的に処理の偏りが発生するリスクがあります。

簡易な構成や小規模環境では十分機能しますが、大規模なシステムでは他のアルゴリズムとの組み合わせが望まれます。

比重(Weighted Round Robin)

比重(Weighted Round Robin)は、ラウンドロビンに重み付けの概念を取り入れた方式です。

各サーバの処理能力や優先度に応じてウェイトを設定することで、より高性能なサーバには多くのリクエストを、低性能なサーバには少なめにリクエストを割り当てられます。

これにより、全体のリソースを効率よく活用することができ、システム全体のバランスが最適化されます。

優先度(Priority-Based)

優先度(Priority-Based)は、あらかじめ定めた優先度順にサーバを使用していく方式です。

通常は最も優先度の高いサーバが常に使用され、障害時や過負荷時にだけ次の優先順位のサーバへ切り替わります。

この方式はフェイルオーバー構成によく使われ、可用性の高いサービス構築に適しています。

優先度を誤って設定すると、一部のサーバだけに偏る恐れがあるため注意が必要です。

最短レスポンス時間(Shortest Response Time)

最短レスポンス時間(Shortest Response Time)は、サーバの応答速度をリアルタイムで監視し、最も応答の速いサーバにリクエストを送るアルゴリズムです。

負荷状況の変動が大きい環境に適しており、ユーザー体験の最適化が期待できます。導入にはレスポンス監視の仕組みが必要で、正確な性能測定が求められる高度な手法です。

最小コネクション数(Least Connections)

最小コネクション数(Least Connections)は、現在の接続数が最も少ないサーバを選んでリクエストを割り振る方式です。

処理時間が一定でないトラフィックや、セッションの持続時間が長いシステムで特に効果的です。

動的な負荷分散に優れており、リアルタイムでのサーバ状況把握が鍵となります。

ルール(Rule-Based)

ルール(Rule-Based)は、URLのパスやヘッダ、Cookie情報など、L7(アプリケーション層)の詳細な情報をもとにリクエストのルートを制御します。

たとえば、/api/以下はAPIサーバに、/image/以下は画像専用サーバに振り分けるといった柔軟な制御が可能です。

パーソナライズやマルチテナント構成、特定ユーザー向けルーティングにも適しており、高度なWebサービス運用には欠かせない方式です。

このように、ロードバランサーの負荷分散アルゴリズムには多様な種類があり、それぞれ得意とするシナリオがあります。

システムの規模や性質、可用性の要件に応じて適切なアルゴリズムを選び、必要に応じて複数の方式を組み合わせることで、より高品質なシステム設計と運用が可能となります。

ソースNAT(Source NAT)

ソースNATとは、ロードバランサーがクライアントからのリクエストをバックエンドサーバに転送する際に、送信元IPアドレスをロードバランサー自身のIPアドレスに書き換える技術です。

この処理によって、バックエンドサーバから見ると、リクエストのすべてはロードバランサーから送られてきたように見えるようになります。

ソースNATを使うメリット

この方式には数多くの利点があります。

まず、バックエンドサーバは各クライアントのIPアドレスを直接意識する必要がなくなり、構成や設定が非常にシンプルになります。

たとえば、個別のクライアントに対してルールを設けたり、特定のアクセス元をホワイトリストやブラックリストに登録するといった煩雑な作業を、ロードバランサー側に集約することができるのです。

さらに、送信元IPを一元的に管理できることにより、ファイアウォールのルール設計やアクセス制御ポリシーの作成が非常に容易になります。

システム運用の効率化や、設定ミスのリスク軽減にもつながります。

また、バックエンドサーバのIP構成が外部から直接見えなくなるため、セキュリティ上も大きなメリットがあります。

攻撃者から見れば、ロードバランサーがすべてのリクエストを処理しているように見えるため、個々のサーバを狙った攻撃の難易度が上がります。

同一ネットワーク内の注意点

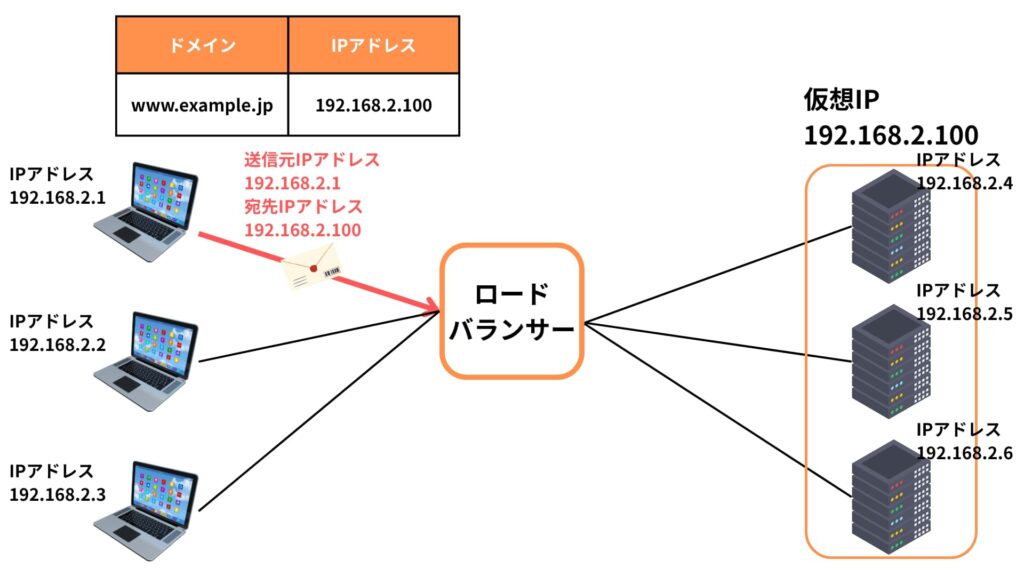

特に注意が必要なのが、クライアントとバックエンドサーバが同じネットワークセグメント内に存在している場合です。

この場合、せっかくロードバランサーを経由してリクエストがサーバに到達しても、レスポンスがクライアントに”直接”返されてしまうことがあります。

どういうことでしょう?

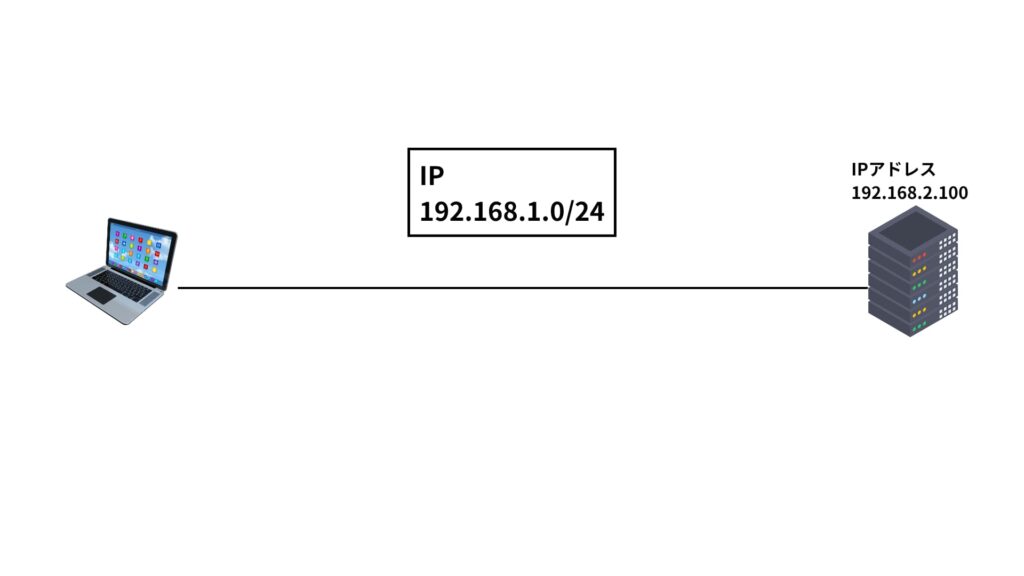

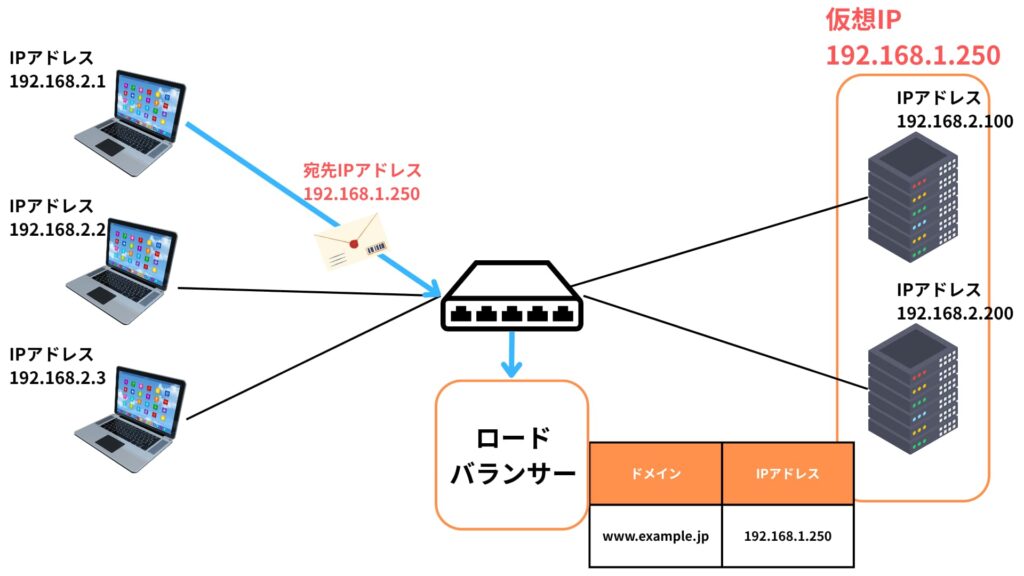

ロードバランサーを導入する以前のネットワーク構成が下記のようだったとします。

ユーザー数が少なくて、1台のサーバで間に合っていたような状況が考えられますね。

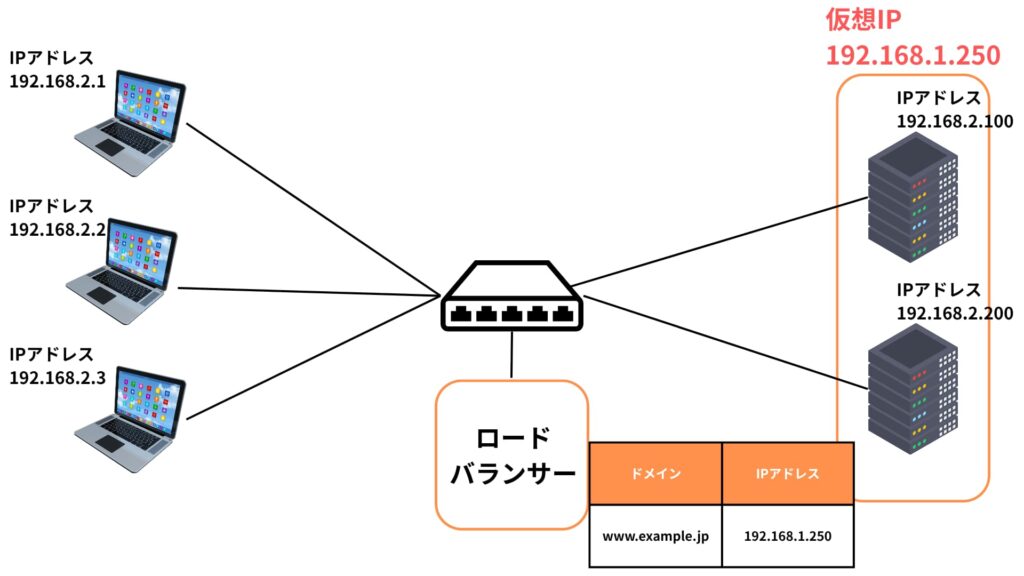

その後、ユーザーが増えてサーバを2台にし、ロードバランサーを導入したとします。

この状況で通信を行うと、通信の流れとIPアドレスは下記のようになります。

ユーザーからは仮想IPアドレス(ロードバランサー)に宛ててデータが送られます。

続いてロードバランサーからサーバ100にデータが渡されます。

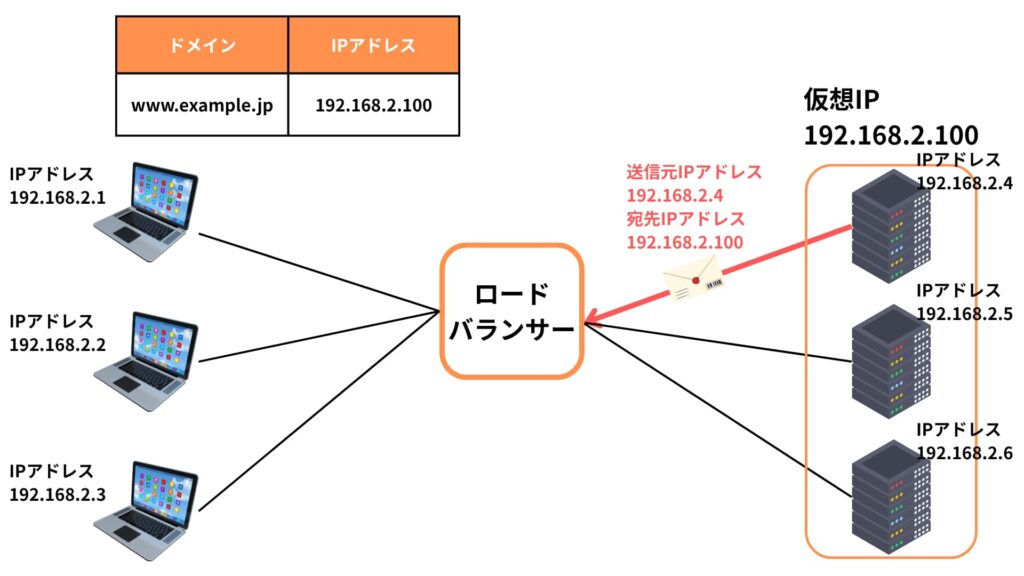

そしてサーバからユーザーにデータを返す際、同一ネットワーク内に相手が居る場合、サーバからユーザーへ直接データを送ることが可能になってしまいます。

これは、IPレイヤーでのルーティングが行われず、MACアドレスをもとにしたL2レベルの通信が優先されるという、ネットワークの基本的な性質に起因します。

つまり、サーバは「同じネットワーク上のクライアントには、ルーターやロードバランサーを経由せず直接返した方が速い」と判断し、ルーティングテーブルに従わずレスポンスを送ってしまうのです。

レスポンスが届かない問題

こうして直接返されたレスポンスですが、クライアントから見ると「自分がリクエストを送った相手(ロードバランサー)ではなく、まったく知らないIPアドレス(バックエンドサーバ)から返ってきたデータ」に映ります。

結果として、不正な通信やスプーフィングと見なされ、そのパケットはクライアントのOSやアプリケーションによって破棄されてしまいます。

このような状況では、通信そのものが成立しなくなり、ユーザーはページが表示されない・操作が効かないといった障害を体験することになります。

特にセキュリティが厳しく設定されたネットワークや業務用端末などでは、より厳格にパケットの出自が確認されるため、こうした不整合は致命的です。

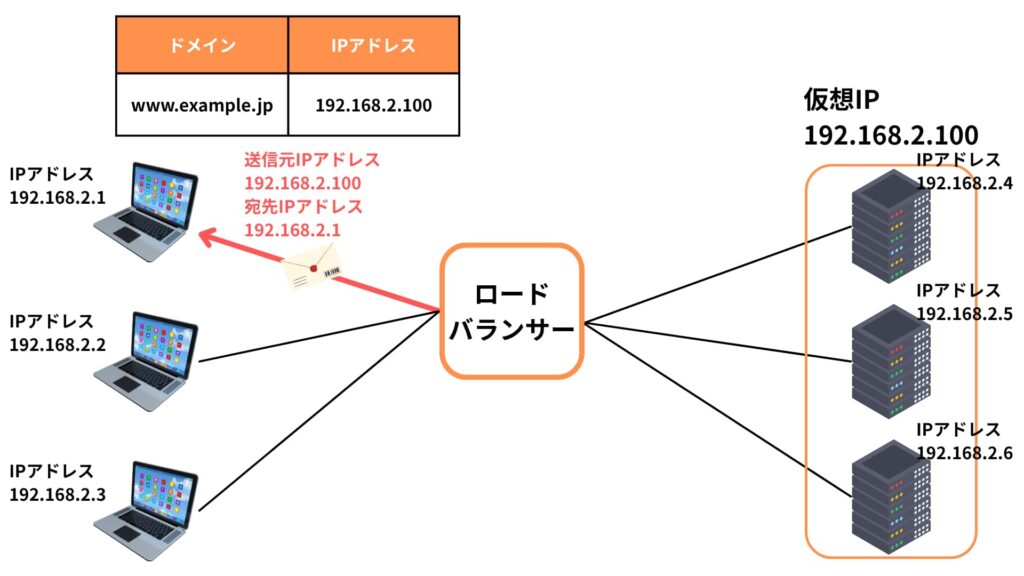

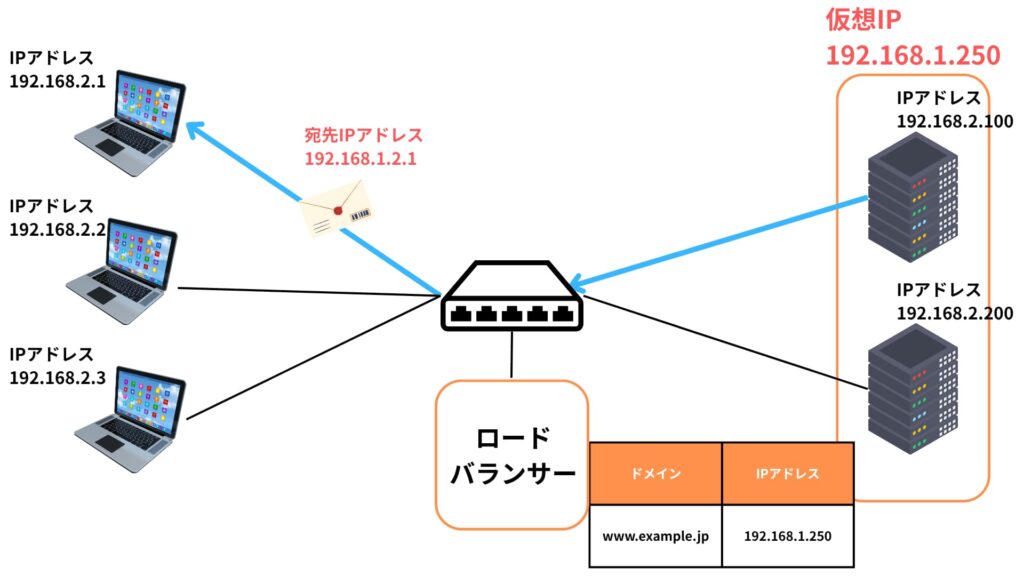

ソースNATで問題を解決

このようなトラブルを回避するために有効なのが、ソースNATです。

ロードバランサーがクライアントの送信元IPアドレスを、自身のIPアドレスに変換することで、バックエンドサーバからのレスポンスは、すべてロードバランサーへ戻るようになります。

その後、ロードバランサーはそのレスポンスを元のクライアントへ正しく転送します。

こうすることで、すべての通信はロードバランサーを起点・終点として整合性を保つことができ、前述のような問題を防ぐことが可能になります。

クライアントIPを失わないために

ただし、ソースNATを行うと、バックエンドサーバは本来のクライアントIPアドレスを受け取ることができなくなります。

これではログに記録される送信元がすべてロードバランサーになってしまい、アクセス解析や不正アクセス対策に支障をきたします。

そこで、一般的な対策としてはHTTPヘッダの追加があります。

多くのロードバランサーでは「X-Forwarded-For」や「X-Real-IP」といったヘッダを自動的に追加する機能があり、これを使えばアプリケーション側でクライアントの本来のIPを把握することが可能になります。

セキュリティポリシーやコンテンツの出し分けなど、クライアントIPに基づいた制御が必要な場合には、このヘッダ情報の活用が不可欠となります。

DSR(Direct Server Return)

DSR(Direct Server Return)は、ソースNATを使用せずにクライアントとサーバ間の通信を行うロードバランシング手法の一つです。

この方式では、クライアントからのリクエストはロードバランサーを経由してバックエンドサーバへ送られますが、レスポンスはロードバランサーを通らず、サーバから直接クライアントに返されます。

この設計により、ネットワーク全体の効率性が大きく向上します。

通信の流れ

通信は一方向のみロードバランサーを経由します。

具体的には

- 行き:クライアント → ロードバランサー → バックエンドサーバ

- 帰り:バックエンドサーバ → クライアント(直接)

レスポンスがロードバランサーを通らないため、帯域消費や処理負荷を大きく抑えることができます。

これは特に大量のトラフィックを処理する環境において、有効なアプローチです。

MACアドレスの書き換えと課題

DSRの通信でユニークな点は、パケットの宛先MACアドレスだけをサーバのものに書き換えるところです。

IPアドレスは仮想IPアドレス(VIP)のままなので、目的のサーバに届いたとき、そのサーバの通常の設定では「自分宛てではない」と判断してしまい、パケットを破棄する可能性があります。

この挙動はOSやネットワークスタックの仕様によるもので、セキュリティを守るために想定外のIPアドレス宛てのパケットを拒否する設計になっているためです。

ループバックインターフェースの利用

そこで、サーバ側で特別な設定が必要になります。

「ループバックインターフェース」という仮想的なネットワークインターフェースに、VIPと同じIPアドレスを割り当てることで、サーバはそのVIP宛てのパケットも自分宛てのものとして受け入れられるようになります。

この構成により、MACアドレスのみがサーバのものであっても、IPアドレスとの不一致が解消され、正常にパケットが処理されるようになります。

ただし、この設定はサーバごとに個別に行う必要があり、初期構築の負荷が若干増します。

DSRのメリットとデメリット

DSRの導入には、メリットとデメリットがそれぞれ存在します。

メリットとしては、システム全体のパフォーマンス向上やトラフィック削減が挙げられ、特に大規模なアクセスを処理する場面で真価を発揮します。

一方で、構成が複雑になることや、既存環境との互換性に配慮する必要があるといった課題もあります。

それぞれを理解して、適切な設計判断を行うことが重要です。

- レスポンスがロードバランサーを経由しないため、通信経路の最適化が可能

- ロードバランサーの処理負荷を軽減でき、大量トラフィックにも対応しやすい

- 通信全体のレイテンシ(遅延)が下がり、より高速な応答が期待できる

- サーバ側のループバック設定など、事前の構成が複雑になりやすい

- 特定のファイアウォールやネットワーク機器との互換性に課題がある

- クライアントのIPアドレスがログやアプリケーションに反映されにくいため、個別対策が必要

このように、DSRは非常に効率的な構成を実現できる一方で、技術的な配慮が必要な場面も多く、導入にあたってはシステム全体の構成やセキュリティポリシーを十分に考慮した判断が重要となります。

ロードバランサーの種類

ロードバランサーには、物理的な専用機器として提供される「ハードウェア型ロードバランサー」、ソフトウェアとして汎用サーバ上に導入される「ソフトウェア型ロードバランサー」、さらにクラウド事業者が提供する「クラウド型ロードバランサー」など、さまざまな種類があります。

それぞれの特徴を理解することで、自社のシステム構成や運用方針に適したロードバランサーを選定しやすくなります。

ここでは代表的なロードバランサーの種類について解説します。

ハードウェア型ロードバランサー

専用の装置として提供されるタイプで、高い性能と信頼性が求められる大規模システム向けに使用されます。

レイヤ4・レイヤ7の両方に対応するものが多く、豊富な機能や高可用性構成を実現できる点が特徴です。

初期導入コストが高めですが、パフォーマンス重視の環境では非常に有効です。

ソフトウェア型ロードバランサー

OS上にインストールして利用するタイプで、比較的低コストで導入でき、自由度が高いのが特徴です。

OSS(オープンソースソフトウェア)として提供される「HAProxy」や「Nginx」などが代表例です。

環境に応じて柔軟にカスタマイズできる反面、性能や信頼性は構成によって左右されやすいため、設計段階でのチューニングが重要です。

クラウド型ロードバランサー

AWSの「Elastic Load Balancing」やGCPの「Cloud Load Balancing」など、クラウドプラットフォームが提供するサービスとしてのロードバランサーです。

インフラのスケーリングと連携して動作するため、自動化や運用効率に優れます。

また、クラウド事業者によって保守されるため、運用負担が軽減される点もメリットです。

このように、ロードバランサーの種類ごとに特性と導入目的が異なります。システムの要件や成長性を見据え、最適なタイプを選ぶことが重要です。

まとめ

ロードバランサーは、現代のWebサービスやクラウドシステムにおいて欠かせない存在です。

アクセスの集中やサーバ障害といったリスクに備え、負荷を分散しながら、安定したサービス提供を実現してくれます。

特に、ソースNATやDSRといった通信方式の理解は、システム設計やトラブル対応において大きな助けとなります。

また、導入するロードバランサーの種類(ハードウェア型・ソフトウェア型・クラウド型)によって、運用やコストにも違いが生じるため、目的や予算に応じた選定が求められます。

サービス品質を支える裏方の技術として、ロードバランサーの知識を深めておくことは、インフラ設計者やネットワークエンジニアにとって大きな武器となるでしょう。